14172970 bayesilibro

-

Upload

bobconstructor -

Category

Documents

-

view

390 -

download

0

description

Transcript of 14172970 bayesilibro

ii

Introduccion a laEstadıstica Bayesiana

Juan Carlos Correa Morales

Escuela de Estadıstica

Universidad Nacional de Colombia

Sede Medellın

2008

Prefacio

Estas notas presentan una introduccion a la estadıstica bayesiana. Este es uncampo que ha tenido un desarrollo impresionante en los ultimos anos, en espe-cial desde la introduccion de la parte computacional. Muchas ideas han estadocirculando desde hace mucho tiempo, pero su imposibilidad practica hacıan quese miraran con cierto pesar, ya que eran muy atractivas pero inaplicables. Estoafortunadamente ha cambiado. Es lamentable los libros basicos en estadısticano hagan una presentacion de los elementos basicos de esta aproximacion parala solucion de problemas estadısticos.

Aquı vamos a presentar una aproximacion eminentemente practica, esto es,el lector puede aplicar de forma casi inmediata los metodos a problemas reales.El software que se utilizara es de dominio publico como el R o de permisolibre para educacion como el WinBUGS. Se requiere familiaridad con el primerprograma al menos a un nivel operativo basico.

Se asume que el lector tiene familiaridad con los metodos estadısticos a unnivel operativo, al menos. Conocimiento de inferencia a un nivel de un textobasico de estadıstica matematica ayuda bastante.

iii

iv

Indice general

1. Introduccion 31.1. Aproximaciones al analisis bayesiano . . . . . . . . . . . . . . . . 61.2. Problemas con la aproximacion clasica . . . . . . . . . . . . . . . 6

2. Probabilidad Subjetiva “Apriori” 92.1. Probabilidad Personal . . . . . . . . . . . . . . . . . . . . . . . . 92.2. Probabilidad Subjetiva y Apuestas . . . . . . . . . . . . . . . . . 92.3. Clasificacion de las Distribuciones Apriori . . . . . . . . . . . . . 102.4. Distribuciones Apriori No Informativas . . . . . . . . . . . . . . . 112.5. Distribuciones Apriori Informativas . . . . . . . . . . . . . . . . . 112.6. Elicitacion de Probabilidades Subjetivas . . . . . . . . . . . . . . 11

2.6.1. Supuestos de Coherencia . . . . . . . . . . . . . . . . . . . 122.7. Formas de Elicitacion . . . . . . . . . . . . . . . . . . . . . . . . 122.8. Un Dialogo para la Obtencion de la Proporcion . . . . . . . . . . 132.9. Analisis preposterior . . . . . . . . . . . . . . . . . . . . . . . . . 17

3. Teorema de Bayes 193.1. Usos de la Funcion de Verosimilitud en Analisis Bayesiano . . . . 22

4. Distribuciones Conjugadas 234.1. Distribucion Binomial . . . . . . . . . . . . . . . . . . . . . . . . 24

4.1.1. Elicitacion de los Parametros de la Beta para Proporciones 264.2. Distribucion Binomial Negativa . . . . . . . . . . . . . . . . . . . 284.3. Distribucion Geometrica . . . . . . . . . . . . . . . . . . . . . . . 284.4. Distribucion Multinomial . . . . . . . . . . . . . . . . . . . . . . 284.5. Distribucion Poisson . . . . . . . . . . . . . . . . . . . . . . . . . 294.6. Distribucion Exponencial . . . . . . . . . . . . . . . . . . . . . . 304.7. Distribucion Normal . . . . . . . . . . . . . . . . . . . . . . . . . 30

4.7.1. Precision Conocida . . . . . . . . . . . . . . . . . . . . . . 304.7.2. Precision Desconocida . . . . . . . . . . . . . . . . . . . . 314.7.3. Media y Precision Desconocidas . . . . . . . . . . . . . . . 31

v

vi INDICE GENERAL

4.8. Distribucion Gamma . . . . . . . . . . . . . . . . . . . . . . . . . 32

5. Distribuciones No Informativas 355.1. El Principio de la Razon Insuficiente de Laplace . . . . . . . . . . 365.2. Apriori de Jeffreys . . . . . . . . . . . . . . . . . . . . . . . . . . 365.3. Otras Alternativas . . . . . . . . . . . . . . . . . . . . . . . . . . 395.4. Marginalizacion . . . . . . . . . . . . . . . . . . . . . . . . . . . . 40

6. Inferencia Bayesiana 436.1. Estimacion Puntual . . . . . . . . . . . . . . . . . . . . . . . . . 436.2. Regiones de Credibilidad . . . . . . . . . . . . . . . . . . . . . . . 496.3. Region de la Densidad Posterior Mas Alta (RDPMA) . . . . . . 49

6.3.1. Intervalos frecuentistas tradicionales para la Poisson . . . 516.4. Pruebas de Hipotesis . . . . . . . . . . . . . . . . . . . . . . . . . 53

6.4.1. Comparacion de Modelos . . . . . . . . . . . . . . . . . . 586.5. La aproximacion BIC . . . . . . . . . . . . . . . . . . . . . . . . . 61

7. Inferencia Predictiva 657.1. Tamano Muestral . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

8. WinBUGS 698.1. Introduccion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 698.2. Que se espera de un software para estadıstica bayesiana? . . . . . 698.3. Utilizacion de WinBUGS . . . . . . . . . . . . . . . . . . . . . . 708.4. Algunos de los comandos del WinBUGS . . . . . . . . . . . . . . 76

8.4.1. Model . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 768.4.2. Inference . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

9. Modelos Lineales 819.1. La regresion clasica . . . . . . . . . . . . . . . . . . . . . . . . . . 81

9.1.1. Usos del Analisis de Regresion . . . . . . . . . . . . . . . 819.1.2. Estrategia Tıpica en un Analisis de Regresion . . . . . . 829.1.3. Regresion simple . . . . . . . . . . . . . . . . . . . . . . . 829.1.4. Modelo de Regresion Lineal Multiple . . . . . . . . . . . 839.1.5. Notacion Matricial . . . . . . . . . . . . . . . . . . . . . . 83

9.2. Aproximacion Bayesiana . . . . . . . . . . . . . . . . . . . . . . . 849.3. Distribucion Normal-Gamma . . . . . . . . . . . . . . . . . . . . 849.4. Distribucion Aposteriori . . . . . . . . . . . . . . . . . . . . . . . 859.5. Analisis Conjugado . . . . . . . . . . . . . . . . . . . . . . . . . . 86

9.5.1. Distribucion Predictiva . . . . . . . . . . . . . . . . . . . 889.5.2. Inferencias . . . . . . . . . . . . . . . . . . . . . . . . . . 899.5.3. Pruebas de Hipotesis . . . . . . . . . . . . . . . . . . . . . 89

9.6. Precios de Oferta de Vehıculos . . . . . . . . . . . . . . . . . . . 909.7. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 929.8. Estrategias en Modelacion . . . . . . . . . . . . . . . . . . . . . . 979.9. Regresion Inversa o Calibracion . . . . . . . . . . . . . . . . . . . 98

INDICE GENERAL vii

10.Modelo Lineal Generalizado 101

10.1. Modelo Logıstico . . . . . . . . . . . . . . . . . . . . . . . . . . . 102

10.1.1. Seleccion de la Distribucion Apriori . . . . . . . . . . . . 102

10.1.2. Analisis Bayesiano de Residuales de Modelos Logısticos . 106

10.2. Regresion Poisson . . . . . . . . . . . . . . . . . . . . . . . . . . . 106

10.3. Log-concavidad de la log-verosimilitud . . . . . . . . . . . . . . . 111

11.Estadıstica Bayesiana Empırica 113

12.Analisis Multivariable 115

12.1. Distribucion Normal Multivariable . . . . . . . . . . . . . . . . . 115

13.Datos Categoricos 117

13.1. Distribucion Multinomial . . . . . . . . . . . . . . . . . . . . . . 117

13.1.1. Obtencion de la prevalencia verdadera from prevalenciaaparente . . . . . . . . . . . . . . . . . . . . . . . . . . . . 120

13.1.2. La Razon de Odds . . . . . . . . . . . . . . . . . . . . . . 122

13.1.3. Modelos Loglineales . . . . . . . . . . . . . . . . . . . . . 123

13.1.4. Tablas con faltantes . . . . . . . . . . . . . . . . . . . . . 123

13.1.5. Estimacion de N (El tamano de toda una poblacion) . . . 123

14.Metodos Computacionales 125

14.0.6. Muestreo de Importancia . . . . . . . . . . . . . . . . . . 128

14.0.7. Muestreo por Rechazo . . . . . . . . . . . . . . . . . . . . 128

14.1. MCMC: Monte Carlo por Cadenas de Markov . . . . . . . . . . . 130

14.1.1. Algoritmo Metropolis-Hastings . . . . . . . . . . . . . . . 131

14.1.2. Muestreador Griddy Gibbs . . . . . . . . . . . . . . . . . 140

14.2. Calculo de Integrales via Simulacion . . . . . . . . . . . . . . . . 141

14.2.1. Composicion . . . . . . . . . . . . . . . . . . . . . . . . . 141

14.3. Metodos Monte Carlo de Cadenas de Markov (MCMC) . . . . . 141

14.3.1. Glosario de Cadenas de Markov . . . . . . . . . . . . . . . 141

14.3.2. Muestreador Gibbs . . . . . . . . . . . . . . . . . . . . . . 142

14.4. Simulacion Exacta . . . . . . . . . . . . . . . . . . . . . . . . . . 142

14.4.1. El Muestreador Perfecto . . . . . . . . . . . . . . . . . . . 142

14.5. Algoritmo E −M . . . . . . . . . . . . . . . . . . . . . . . . . . . 144

14.5.1. Modelo Probit para Datos Binarios . . . . . . . . . . . . . 144

14.6. Diagnosticos de los Muestreadores MCMC . . . . . . . . . . . . . 146

14.6.1. Monitoreo y Convergencia de una MCMC . . . . . . . . . 147

15.Modelos Jerarquicos 165

15.1. Meta-analisis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 166

16.Datos 169

16.1. Apellidos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 169

16.2. Mordeduras . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 171

INDICE GENERAL 1

17.Probabilidad Subjetiva: Fundamentos 18317.1. Verosimilitud Relativa . . . . . . . . . . . . . . . . . . . . . . . . 18317.2. El Experimento Auxiliar . . . . . . . . . . . . . . . . . . . . . . . 185

18.Referencias 187

2 INDICE GENERAL

Capıtulo 1Introduccion

La escuela bayesiana en estadıstica ha tomado fuerza en los ultimos anosdebido a su potencial para resolver problemas que no se pueden atacar conotros metodos y porque permite incorporar naturalmente informacion que esutil en la solucion del problema enfrentado. El siguiente ejemplo ilustra unasituacion tıpica:

Ejemplo 1.1 La loterıa que jugo anoche Suponga que a usted un amigo leofrece un billete de loterıa, pero con el problema que la loterıa jugo anoche. Suamigo, que ha demostrado ser una persona honesta le informa que el no sabe elresultado de la loterıa, y usted tampoco. En una situacion como esta podemospensar en una probabilidad de que el billete sea el ganador es la misma que elbillete tenıa antes de que se jugara la loterıa, no lo piensa ası?

Nadie niega que ante un problema debemos utilizar toda la informaciondisponible acerca de un problema particular. Para nuestro caso estadıstico laincertidumbre sobre paramteros poblacionales se resume por medio de distribu-ciones de probabilidad, que anterior a recoger informacion muestral relevantepara ellos, se conoce como ‘distribucion apriori.’ El problema esta en la formade cuantificar esta informacion sin generar alguna contradiccion.

Un problema que se ha planteado cuando se habla de la escuela bayesianaes que dos personas enfrentadas ante un problema y una decision a tomar,y asumiendo que tengan la misma informacion muestral, pueden llegar a dosdecisiones opuestas si su informacion adicional es diferente. Greenland (2001)afirma que “los epidemiologos perciben la especificacion de la distribucion aprioricomo impractica y ademas pocos epidemiologos emplearıan metodos que noestan disponibles en paquetes estadısticos lıderes.”

Albert (1997) presenta las siguientes razones por las cuales se deberıa ensenarestadıstica desde el punto de vista bayesiano:

3

4 CAPITULO 1. INTRODUCCION

El paradigma bayesiano es un medio natural de implementar el metodocientıfico donde la distribucion apriori representa sus creencias inicialesacerca del modelo, usted recoge los datos adecuados, y la distribucionposterior representa sus creencias actualizadas despues de ver los datos.

Si la incertidumbre acerca de los modelos es expresada utilizando proba-bilidad subjetiva, entonces la regla de Bayes es la unica receta que unonecesita para realizar inferencias de los datos.

Las afirmaciones inferenciales bayesianas son mas faciles de entender quelas basadas en la inferencia tradicional basadas en muestreo repetido. Laprobabilidad que un parametro caiga dentro de un intervalo calculado esigual a 0.95. Tambien, en contraste con los procedimientos tradicionalesde pruebas de hipotesis, tiene sentido hablar acerca de la probabilidad queuna hipotesis estadıstica sea cierta.

Por el principio de condicionalidad, los unicos datos relevantes para eje-cutar inferencias son los datos realmente observados. Uno puede ignorarotros resultados de un espacio muestral que no son observados.

Los problemas de prediccion no son mas difıciles que los problemas de esti-macion de parametros. Parametros y observaciones futuras son cantidadesdesconocidas que son modeladas subjetivamente.

Ejemplo 1.2 Estatura de los colombianos. Si pensamos en la estaturapromedio de los hombres colombianos podemos pensar seriamente que este valorno es mayor que 180 cms. ni menor que 160 cms. Es claro que si conocemosmuchos hombres colombianos nuestra informacion puede utilizarse en un procesoinferencial, pero confiarıamos mas si la informacion sobre la estatura provienede algun estudio previo realizado sobre el mismo tema.

Ejemplo 1.3 La nota esperada. A un estudiante que acaba de presentarun examen se le puede preguntar cual sera su nota esperada. Con base en supropio conocimiento de su capacidad y de su preparacion, de como respondio elexamen el puede tener una idea sobre la nota que espera obtener al ser calificadosu examen. Obviamente la nota exacta no la conoce ya que existen multiplesfactores que entran en una evaluacion, pero puede proporcionar un rango dentrodel cual se sienta muy seguro.

Ejemplo 1.4 Sobre una proporcion. Ya que estamos familiarizados conel tipo de estudiantes que estan en este lugar, podemos establecer valores entrelos cuales creemos cae el porcentaje de mujeres que estudian en la universidad.

La aproximacion bayesiana es una herramienta fundamental en situacionesdonde la recoleccion de informacion muestral sea muy difıcil, por ejemplo en

5

topicos de alta sensibilidad social o extremadamente costosa o imposible, comoserıa el caso de la determinacion del riesgo de falla de una nueva nave espacialo cual es la probabilidad de que haya vida inteligente en nuestra galaxia. Unproblema adicional es como cuantificar la informacion que se tenga.

Ejemplo 1.5 Porcentaje de estudiantes que consumen una droga. Siqueremos determinar el porcentaje de estudiantes que consumen un tipo de dro-gas, podemos utilizar la informacion que se haya recogido en estudios pasados.

Ejemplo 1.6 Tasa de estudiantes que ejercen la prostitucion. Si quer-emos determinar el porcentaje de estudiantes que ejercen la prostitucion ennuestra universidad, no parece facil resolver esto mediante una simple encuesta,aunque es posible utilizar procedimientos como el de la respuesta aleatorizada,el hecho de enfrentar un encuestador puede llevar a dar respuestas socialmenteaceptables.

Las ideas iniciales de la probabilidad surgieron relacionadas con los juegosde azar y su interpretacion es basicamente frecuentista. Esta formulacion fre-cuentista trabaja bien en muchas situaciones, pero no en todas.

Una caracterıstica distintiva de la estadıstica bayesiana es que tiene en cuentade forma explıcita la informacion previa y se involucra en el analisis en forma dedistribucion, llamada distribucion apriori. La teorıa clasica la considera basica-mente para determinar tamanos muestrales y el diseno de experimentos y, aveces, como forma de crıtica de los resultados hallados.

La expresion de la informacion previa en forma cuantitativa puede ser unproceso complejo y delicado, aunque se han hallado soluciones que pueden lle-gar a parecer extranas, como lo puede ser el uso de lo que se conoce comodistribuciones no informativas, pero que se utilizan extensamente en el trabajobayesiano aplicado.

Fuentes tradicionales para la construccion de la distribucion apriori son:

Estudios previos similares. La utilizacion de estudios previos sobre unospocos parametros especıficos ha dado origen a un area conocida comometanalisis, la cual puede trabajarse desde el punto clasico y bayesiano.Un problema cuando se trabaja con datos sacados de pubicaciones y nocon los estudios originales, es el que se conoce como sesgo de publicacion,que hace referencia a la publicacion, por parte de los editores o autores,solo a aquellos resultados que son significativos.

Opinion de expertos. La utilizacion de expertos es casi obligatoria en situa-ciones completamente nuevas donde experimentar puede ser muy costoso,por ejemplo en la implementacion de polıticas a nivel macroeconomico.

6 CAPITULO 1. INTRODUCCION

1.1. Aproximaciones al analisis bayesiano

Esta seccion esta basada en Berger (1999).

1. Analisis bayesiano objetivo: Esta posicion se caracteriza por la utilizacionde distribuciones no informativas.

2. Analisis bayesiano subjetivo: La utilizacion de distribuciones apriori sub-jetivas es a menudo disponible como alternativa en algunos problemas.

3. Analisis bayesiano robusto: Esta posicion asume que es imposible especi-ficar completamente la distribucion apriori o el modelo, en cuyo caso esmejor trabajar dentro de clases donde haya un nivel de incertidumbresobre esta distribucion o modelo.

4. Analisis bayesiano-frecuentista: Hay problemas en los cuales la aproxi-macion frecuentista produce resultados satisfactorios, como en los meto-dos no parametricos, y al bayesiano le toca aceptarlos como solucionesseudobayesianas.

5. Analisis cuasibayesiano: Esta aproximacion utiliza distribuciones aprioriseleccionadas de una forma que acomoden a la solucion “bonita” del prob-lema, ajustando estas distribuciones apriori de diversas formas, por ejem-plo seleccionando distribuciones apriori vagas, o ajustando los parametros.

1.2. Problemas con la aproximacion clasica

Harrell (1998) ha presentado algunos de los problemas que ocurren con laaproximacion clasica a varios problemas estadısticos:

1. En pruebas de hipotesis:

Un experimento proporciona los elementos para una posibilidad derechazar la hipotesis nula.

El rechazo de una hipotesis nula es diferente de su rechazo logico.

Una hipotesis contradicha por los datos (un valor-p pequeno) significaque un evento improbable ha ocurrido, o que la hipotesis nula es falsa,o ambas.

Que hacer si la hipotesis nula no es rechazada?

De acuerdo a Fisher una hipotesis nula nunca es aceptada.

Cual estadıstico de prueba utilizar?

• No hay una regla general sobre cual estadıstico de prueba utilizar.

• Diferentes estadısticos pueden llevar a diferentes conclusiones delmismo analisis.

1.2. PROBLEMAS CON LA APROXIMACION CLASICA 7

• Se pueden obtener conclusiones inconsistentes de manera logi-ca, por ejemplo colapasando tablas de contingencia y realizandopruebas χ2.

En la teorıa de Neyman-Pearson una prueba estadıstica de hipotesis(Ho) no esta sola sino contra teorıas competidoras (H1). Se puedencometer dos tipos de errores y la idea es tener probabililidades deambos errores tan pequenas como sean posibles. El problema es deinterpretacion: Que significa aceptar o rechazar?

En ambas escuelas no hay probabilidades de que las teorıas seancorrectas.

Problemas con los valores-p.

• Solo pueden ser utilizados como evidencia contra una hipotesis,no proporcionan evidencia a favor de una hipotesis.

• Valores-p iguales no proporcionan igual evidencia acerca de unahipotesis.

• Si usamos valor-p < 0,05 como un evento binario, la evidencia esmayor en estudios mas grandes.

• Si usamos el valor-p real, la evidencia es mayor en estudios maspequenos.

Muchos resultados pueden ser estadısticamente significativos debidoa un n grande y no a una diferencia significativa.

2. En estimacion:

Los intervalos de confianza son a menudo malinterpretados

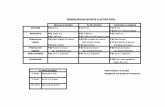

Diferencias entre la teorıa clasicay la teorıa bayesiana

Caracterıstica Teorıa Clasica Teorıa BayesianaParametros de interes Constantes desconocidas Variables aleatoriasDistribucion apriori No existe Existe y es explıcitaModelo muestral Se asume Se asumeDistribucion posterior No existe Existe y se derivaRazonamiento Inductivo Deductivo

Utilizaremos la siguiente notacion:

θ′ = (θ1, · · · , θk) Vector de parametrosx1, · · · , xn Observaciones muestrales (i.i.d.)ξ(θ) Distribucion apriori conjunto de Θf(xi|θ) Distribucion de Xi dado θ

8 CAPITULO 1. INTRODUCCION

Capıtulo 2Probabilidad Subjetiva “Apriori”

El trabajo estadıstico descansa en el concepto de probabilidad. La definicionmatematica es clara: Es una funcion aditiva no negativa, cuyo maximo valores la unidad (Jackman). El problema fundamental esta en la forma como sedetermine esa funcion.

2.1. Probabilidad Personal

Horowitz (1968) define la probabilidad como

“La probabilidad no es sino un numero ındice entre 0 y 1, queexpresa un pensamiento del individuo sobre la posibilidad del resul-tado, relativo, de una experiencia... Debemos por tanto, reconocerque podemos evaluar la probabilidad, bien cuando el suceso es unicoo se trata de un suceso de caracter repetitivo, que pueda presen-tarse en varias pruebas. El hecho de que el suceso vaya a ocurrir unavez no impide que un individuo pueda formar un juicio acerca de loprobable que suceda respecto a otros posibles resultados; es decir,puede asignar probabilidades a cada uno de los posibles resultados.”

2.2. Probabilidad Subjetiva y Apuestas

Las creencias pueden ser expresadas en terminos de apuestas, esto se hacemucho en la practica, y esto puede ser utilizado como una forma general de hacerlas creencias relativas explıcitas (D’Agostini, 2000). Hay condiciones naturalesa ser impuestas sobre las apuestas:

La apuesta debe ser reversible y que ninguna apuesta pueda ser elaboradatal que uno pierda o gane con certeza. Esta condicion obliga al sujeto aasignar las apuestas consistentemente con sus creencias.

9

10 CAPITULO 2. PROBABILIDAD SUBJETIVA “APRIORI”

La anterior tambien obliga a aceptar la segunda condicion: una vez el hafijado los odds, el debe estar preparado para apostar en cualquier direccion.Esta coherencia juega dos papeles importantes:

1. es moral y obliga a la gente a ser honesta,

2. y otro formal, que permite que las reglas basicas de la probabilidadsean derivadas como teoremas.

Es evidente que “subjetividad” no se puede confundir con “arbitrariedad”,ya que todos los elementos para la asignacion de probabilidades deben tenerseen cuenta, incluyendo el conocimiento que otros puedan asignar a las diferentesposibilidades de los mismos eventos.

2.3. Clasificacion de las Distribuciones Apriori

Distribuciones Apriori =

PropiasImpropias

Definicion 2.1 (Distribucion Apriori Propia) Es una distribucion que asignapesos no negativos y que suman o integran hasta uno, a todos los valores posiblesdel parametro.

Ası, una distribucion propia satisface las condiciones de funcion de densidadde probabilidad. Una distribucion impropia es la que suma o integra a un valordiferente de uno, digamos K. Si K es finito, entonces la distribucion impropiainduce una distribucion propia normalizando la funcion. Si K es infinito, en-tonces la distribucion tiene un papel de ponderacion o de herramienta tecnicapara llegar a una dsitribucion posterior.

Distribuciones Apriori =

InformativasNo informativas

Definicion 2.2 (Distribucion Apriori No Informativa) Decimos que unadistribucion apriori es no informativa cuando refleja una ignorancia total o unconocimiento muy limitado sobre el parametro de interes.

El area de las distribuciones no informativas es grande y polemica. Existendiferentes posiciones sobre como reflejar ignorancia mediante una distribucion.A este tema le dedicaremos una seccion ya que es de crucial importancia enestadıstica bayesiana.

Distribuciones Apriori =

ConjugadasNo conjugadas

Definicion 2.3 (Distribucion Apriori Conjugada) Decimos que una dis-tribucion apriori es conjugada, si al proceder a su actualizacion mediante lainformacion muestral, la distribucion aposteriori es igual a la apriori, exceptoen los hiperparametros.

2.4. DISTRIBUCIONES APRIORI NO INFORMATIVAS 11

2.4. Distribuciones Apriori No Informativas

En muchas ocasiones sabemos nada o muy poco acerca del parametro deinteres o no queremos involucrar en nuestro estudio informacion previa, sinomas bien dejar que sean los datos los que “hablen por ellos mismos”. En estecaso la distribucion debe reflejar nuestro total desconocimento de los valoresposibles del parametro. Esta es un area de trabajo que ha crecido enormemente.

2.5. Distribuciones Apriori Informativas

Una de las mayores dificultades en la ejecucion de un analisis bayesianoconcierne con la identificacion, de la seleccion y la justificacion de la distribucionapriori. Preguntas como:

Que clase de distribucion apriori debemos utilizar?

Que tipos de datos estan disponibles para seleccionar el modelo apriori?

Como cuantificificamos la informacion subjetiva?

Como ajustamos la distribucion apriori con los datos subjetivos disponibles?

deben ser resueltas sin lugar a dudas.

2.6. Elicitacion de Probabilidades Subjetivas

En muchas situaciones es de importancia cuantificar la informacion subjetivaque sobre la posibilidad de la ocurrencia de un evento sientan uno o variosindividuos. La idea es entonces “desarrollar metodos que ayuden a la personaque asigna las probabilidades, las asigne de acuerdo con sus juicios” ( Winkler,1967a, 1967b). Esta tarea es difıcil y puede llegar a ser frustante.

En esta asignacion de probabilidades personales a eventos hay dos requisitos:

1. La asignacion debe obedecer ciertos postulados de coherencia, y

2. las asignaciones deben corresponder a los juicios de la persona.

Es facil chequear el primer punto, pero en el segundo una probabilidad asig-nada a un evento es el resultado de la interaccion de numerosas creencias ojuicios que solo existen en la mente de la persona. Y hay que tener en cuentaque esta asignacion se realiza en un punto del tiempo y que la misma personapuede revisarlas a la luz de nueva informacion. Uno definitivamente no puedeprobar que las probabilidades asignadas corresponden realmente a los juicios dela persona.

12 CAPITULO 2. PROBABILIDAD SUBJETIVA “APRIORI”

2.6.1. Supuestos de Coherencia

Asumimos que la persona que asigna las probabilidades subjetivas medianteinterrogacion directa, posee las siguientes condiciones ideales:

1. Ella nunca viola el supuesto de coherencia.

2. Ella entiende perfectamente los metodos utilizados para la asignacion deprobabilidades. Esto es, ella entiende las alternativas que se le presentany las implicaciones de cada alternativa.

3. Ella tiene una funcion de utilidad que es lineal con respecto al dinero enel rango relevante. Ademas, ella escoge sus respuestas de tal forma quemaximiza su utilidad esperada.

2.7. Formas de Elicitacion

Una forma de asignacion de probabilidades es la interrogacion directa, queconsiste en preguntas que conciernen con

las probabilidades,

CDF (Funcion de Distribucion Acumulada)

PDF (Funcion Densidad de Probabilidad)

• No parametrica

• Parametrica.

Ejemplo 2.1 Para ilustrar esta situacion consideremos este ca-so presentado en Bracken (1966). Supongamos que una personaquiere asignar una distribucion apriori beta a la variable aleato-ria π que representa el voto liberal en una eleccion futura comola fraccion del total de votos. Asumamos que el encuentra difıcilasignar un valor esperado subjetivo al valor de π, pero es capazde expresar sus juicios asignando una probabilidad de 0.50 a laafirmacion π ≤ 0,50 y asignando una probabilidad de 0.75 a laproposicion π ≤ 0,60.

prevision de muestras futuras,

HFS (Muestras Hipoteticas Futuras)

EPS (Informacion Muestral Apriori Equivalente)

apuestas,

loterıas hipoteticas,

graficos de distribuciones de probabilidad, etc.

2.8. UN DIALOGO PARA LA OBTENCION DE LA PROPORCION 13

Oakley y O’Hagan (2002) consideran el caso de elicitacion de la informacionapriori de un sujeto que solo puede dar informacion parcial. De todas formasen un proceso de elicitacion hay incertidumbre con relacion a la informacionproporcionada por el experto. Ellos se limitan al caso en el cual el expertoproporciona informacion sobre un θ observable.

Chesley (1978) hace una comaparacion entre diferentes metodos de elic-itacion. la tecnica usada para la elicitacion afecta como el sujeto mira el prob-lema, la exactitud de sus respuestas y la consistencia de las mismas.

2.8. Un Dialogo para la Obtencion de la Pro-porcion

El siguiente dialogo ilustra una posible forma de elicitar informacion sobreuna proporcion y es presentado en Raiffa (1970)

Analista: Quisiera mostrarle una forma de obtener una distribucion de prob-abilidad subjetiva acerca de una proporcion π. Quiero elegir un contextoque sea lo suficientemente significativo para usted porque sus opiniones sonlas que interesan. Consideremos la poblacion de medicos no abstemios enColombia. Supongamos que π es la propocion de estos bebedores que con-sumieron mas cerveza que aguardiente durante el ultimo ano. Por cierto,sabe usted algo de los habitos alcoholicos de los medicos?

Cliente: No mucho. Conozco personalmente a tres o cuatro medicos, pero meimagino que los doctores no seran muy diferentes de los abogados, losdentistas o los ingenieros. El problema es que no sabrıa responder a supregunta para cualquiera de esos grupos. No tengo ni la mas remota ideadel valor de π.

Analista: Bueno. Esto es justamente lo que querıa.

Cliente: Supongo que quiere que haga una prediccion optima de π. No se sipodrıa hacerlo.

Analista: No, no es eso lo que quiero. De hecho no creo que tenga sentidohablar de una prediccion “optima”. Optima para que? Dejeme hacerle unaspreguntas de precalentamiento. Cree usted que es probable que π sea menoro mayor que 0.10?

Cliente: Mayor, seguro.

Analista: Es probable que π sea mayor o menor que 0.90?

Cliente: Menor.

Analista: Estas preguntas eran faciles. Vea usted, ya sabe algo sobre π. Ahoraquiero que piense bien antes de contestarme. Deme una proporcion tal quesea extremadamente difıcil decidir si es probable que π sea mayor o menor

14 CAPITULO 2. PROBABILIDAD SUBJETIVA “APRIORI”

que ese valor. En otras palabras, quiero que me de un valor para el quecrea que es igualmente probable que π sea mayor o menor que el.

Cliente: (Despues de pensar un rato). Yo dirıa que 0.60. Pero no estoy nadaseguro. Creo que la mayorıa de los medicos prefieren tomar cerveza.

Analista: No se preocupe demasiado; si quiere cambiar de opinion mas tarde,no hay inconveniente. Me acaba de decir que cree que es igualmente prob-able que π sea mayor o menor que 0.60.

Cliente: Exactamente. Pero no me pida que defina lo que significa “igualmenteprobable”.

Analista: Por “igualmente probable” , en este contexto, quiero decir que ust-ed es indiferente entre recibir un premio muy deseable condicionado aque π sea menor que 0.60, y recibir este mismo premio condicionado aque π sea mayor que 0.60. O, de forma mas dramatica, si su vida de-pendiera de ello, optarıa igualmente por un π ≤ 0,60 que por un π ≥ 0,60.Esta siguiendome?

Cliente: Hasta ahora sı.

Analista: Esencialmente, me acaba de decir, y usted lo cree, que 0.60 divideel intervalo de cero a uno en dos partes igualmente probables,en su opi-nion. Ahora voy a pedirle que repita este proceso de dividir imaginaria-mente diferentes intervalos en dos partes igualmente probables. Por ejem-plo, que cree usted que es mas probable, que π sea menor que 0.20 o queeste comprendido entre 0.20 y 0.60?

Cliente: Entre 0.20 y 0.60.

Analista: Entre cero y 0.58, o entre 0.58 y 0.60?

Cliente: Entre 0 y 0.58.

Analista: De acuerdo. Ahora deme un numero para el que crea que es igual-mente probable que π este comprendido entre cero y ese numero y esenumero y 0.60.

Cliente: Que ocurre si π es mayor que 0.60?

Analista: Tal como estan las cosas usted pierde. Mire, si me dice que el numeroes π∗, esto quiere decir que sus probabilidades de ganar el premio sonigualmente buenas si elege el intervalo de cero a π∗ como lo son si elige elintervalo de π∗ a 0.60. Si π es mayor que 0.60 , no obtendrıa el premiosea cual sea el lado de π∗ que elija, porque π no estarıa en esos intervalos.

Cliente: De acuerdo. Veamos... Dire que 0.50 divide el intervalo de cero a 0.60en dos partes igualmente probables.

2.8. UN DIALOGO PARA LA OBTENCION DE LA PROPORCION 15

Analista: Le hubiera sido mas facil si, una vez que me habıa dado el numero0.60 le hubiera hecho la ultima pregunta de esta otra manera?: “Mire,suponga que le digo que π es menor que 0.60. Como dividirıa ahora elintervalo de cero a 0.60 en dos partes igualmente probables?”

Cliente: Son iguales las preguntas?

Analista: Creo que sı. Pienselo.

Cliente: Supongo que son iguales. La segunda me parece mas facil, pero lascosas siempre me parecen mas faciles a la segunda vez.

Analista: Continuemos. Imagınese que le digo que π es mayor que 0.60. Comodividirıa el intervalo 0.60 a 1 en dos partes igualmente probables?

Cliente: 0.70. El intervalo de 0.60 a 0.70 me parece igualmente probable quelos valores superiores a 0.70. Pero realmente me siento un poco incomodoacerca de 0.50 y 0.70 porque el 0.60 es muy poco firme. Me parece comosi estuviera construyendo sobre una esponja. Espero que se de cuenta deque estos numeros son muy poco firmes.

Analista: Me doy cuenta de ello. Animo! Ahora me ha dado tres numeros,0.60, 0.50 y 0.70. Voy a dibujar un intervalo de cero a 1 y colocar estospuntos en el.

0 1

Me acaba de decir que, en lo que a usted respecta, cree que es igualmenteprobable que π este situado en cualquiera de los cuatro intervalos [0 a0.50], [0.50 a 0.60], [0.60 a 0.70] y (0.70 a 1.00].

Cliente: Si, creo que eso es lo que he dicho.

Analista: Ahora voy a comprobarlo. No pretendo confudirle ni molestarle, peroes importante considerar estas cuestiones desde todos los angulos. Porejemplo, prefirirıa usted apostar que π esta en el intervalo [0.50 a 0.70 ]o apostar que esta fuera de este intervalo?

Cliente: Creo que apostarıa que esta dentro del intervalo. Pero estoy siendoinconsistente, no?

Analista: Sı, lo esta siendo, pero es normal. Quiero que piense mas sobre ello.Es una ventaja que trate conscientemente de ser consistente.

Cliente: Bien, no quiero cambiar el 0.60. Me siento mas inseguro con el 0.70.Supongo que estarıa dispuesto a admitir un 0.68. En lo que a mı respecta,hay una probabilidad del 50-50 de que π este en el intervalo [0.50 a 0.68].

Analista: Estarıa dispuesto a decir que es igualmente probable que π este enel intervalo [0.60 a 0.68] o en el intervalo [0.68 a 1]?

16 CAPITULO 2. PROBABILIDAD SUBJETIVA “APRIORI”

Cliente: De acuerdo, lo admitire. Pero, si lo hicieramos todo otra vez y siborrara esta convesacion de mi memoria, puedo imaginar que, en lugar determinar con los numeros 0.50, 0.60 y 0.68, podrıa haber terminado connumeros como 0.52, 0.64 y 0.74.

Analista: Bien, podrıa usted imaginar terminar con numeros tales como 0.20,0.40 y 0.55?

Cliente: No. Realmente no. Pero, que harıa si yo dijera “Sı”?

Analista: Seguirıa presionandole y utilizarıa algun sistema de promedios queseparara aun mas los tres que me ha dado. Pero, continuemos. Me referire alnumero 0.60 como su percentil 0.50, al numero 0.50 como su percentil 0.25y al numero 0.68 como su percentil 0.75. Necesito unos cuantos porcentajesmas. Como dividirıa usted el intervalo [0 a 0.50] en dos partes igualmenteprobables?

Cliente: 0.42.

Analista: Ahora divida el intervalo [0 a 0.42]

Cliente: Me esta forzando un poco demasiado.

Analista: Bien. Suponga que yo le dijera que π es menor que 0.42. Preferirıaapostar por el intervalo [0 a 0.21] o por el intervalo [0.21 a 0.42]?

Cliente: Por el ultimo, por supuesto. De acuerdo, utilice 0.36.

Analista: Ahora pasemos al extremo superior. Divida [0.68 a 1.00].

Cliente: Utilice 0.75.

Analista: De acuerdo. Divida [0.75 a 1.00].

Cliente: Utilice 0.80.

Analista: Resumamos sus respuestas en una tabla:

Distribucion Subjetiva del ClientePercentil Valor del Percentil0.0625 0.360.125 0.420.25 0.500.50 0.600.75 0.680.875 0.750.9375 0.80

Esta discusion puede continuar por largo tiempo y a medida que el clientees mas y mas consciente del proceso de elicitacion y su informacion es cada vezmejor.

2.9. ANALISIS PREPOSTERIOR 17

2.9. Analisis preposterior

Martz y Waller (1982) recomiendan lo siguiente para garantizar la realizacionde un buen analisis bayesiano:

Una justificacion y analisis detallados de la distribucion apriori selecciona-da, con un claro entendimiento de las implicaciones matematicas de laapriori,

Una documentacion completa de las fuentes de datos utilizados en la iden-tificacion y seleccion de la apriori,

Un analisis preposterior de la distribucion apriori con resultados de pruebahipoteticos,

Una distribucion aposteriori claramente definida para los parametros deinteres,

Un analisis de sensibilidad de las inferencias bayesianas para el modeloapriori seleccionado.

18 CAPITULO 2. PROBABILIDAD SUBJETIVA “APRIORI”

Capıtulo 3Teorema de Bayes

El Teorema de Bayes es ahora una de las piedras fundamentales del trabajoestadıstico y sigue siendo de cierta discusiones tanto de sus orıgenes como de susimplicaiones filosoficas (Dawid, 2004). Este teorema fue publicado varios anosdespues de la muerte de reverendo Thomas Bayes por un amigo.

Teorema 3.1 (Teorema de Bayes) Sean B1, B2, · · · , Bk eventos mutuamenteexcluyentes y exhaustivos. Para cualquier evento nuevo A, tenemos

P (Bi|A) =P (Bi

⋂A)

P (A)=

P (A|Bi)P (Bi)∑ki=1 P (A|Bi)P (Bi)

Prueba: (Ejercicio)

Teorema 3.2 (Teorema de Bayes para Variables Aleatorias) Sean X yθ variables aleatorias con fdp’s f (x|θ) y ξ(θ).

ξ (θ|x) =f (x|θ) ξ(θ)∫

Θf (x|θ) ξ(θ) dθ

Dentro del marco bayesiano tenemos que:

X : Datos (escalar o vector o matriz)

θ: Parametro desconocido (escalar o vector o matriz)

f (x1, · · · , xn|θ): Verosimilitud de los datos dado el parametro (desconoci-do) θ.

ξ(θ): Distribucion apriori de θ.

19

20 CAPITULO 3. TEOREMA DE BAYES

Por el teorema anterior

ξ (θ|x1, · · · , xn) =f (x1, · · · , xn|θ) ξ(θ)∫

Θf (x1, · · · , xn|θ) ξ(θ) dθ

Esta es llamada la distribucion posterior. La inferencia bayesiana se derivade esta distribucion. En la practica, el denominador de la expresion anterior nonecesita ser calculado en general, y la regla de Bayes se escribe como

ξ (θ|x1, · · · , xn) ∝ f (x1, · · · , xn|θ) ξ(θ)

Por lo tanto solo necesitamos conocer la distribucion posterior hasta una con-stante de normalizacion. Muchas veces somos capaces de identificar la distribu-cion posterior de θ mirando solamente este numerador. El teorema de Bayes loque hace es una “actualizacion” de ξ(θ) a ξ (θ|x1, · · · , xn).

Nota: El aprendizaje bayesiano sera

ξ (θ|x1) ∝ f (x1|θ) ξ(θ)ξ (θ|x1, x2) ∝ f (x2|θ) f (x1|θ) ξ(θ)

∝ f (x2|θ) ξ (θ|x1)

Por lo tanto el teorema de Bayes nos muestra como el conocimiento acercadel estado de la naturaleza representada por θ es continuamente modificada amedida que nuevos datos son adquiridos.

Ejemplo 3.1 Distribucion Apriori Uniforme Truncada Muchas vecessomos capaces en un problema binomial de especificar claramente en que regiones imposible que este el parametro, pero somos incapaces de especificar mejornuestro conocimiento sobre el. Podemos pensar en utilizar una distribucion apri-ori que refleje esta ignorancia, para ello considremos una uniforme truncada, estoes,

π ∼ U (π0, π1)

Esto es,

ξ (π|π0, π1) =1

π1 − π00 ≤ π0 < π < π1 ≤ 1

La distribucion posterior de π dado x es

ξ (π|x, π0, π1) =

Γ(n+2)Γ(y+1)Γ(n−y+1)π

(y+1)−1(1 − π)(n−y+1)−1

∫ π1

π0

Γ(n+2)Γ(y+1)Γ(n−y+1)π

(y+1)−1(1 − π)(n−y+1)−1dπ

donde y =∑ni=1 xi. Notemos que el denominador de la funcion es la P (π0 < W < π1|y + 1, n− y + 1),

donde W ∼ Beta(y + 1, n − y + 1), y esto se calcula facilmente en programascomo el R.

21

Es facil hallar la media y la varianza aposteriori. Ellas son

E (π|x, π0, π1) =y + 1

n+ 2

P (π0 < W < π1|y + 2, n− y + 1)

P (π0 < W < π1|y + 1, n− y + 1)

y

V ar (π|x, π0, π1) =(y + 2)(y + 1)

(n+ 3)(n+ 2)

P (π0 < W < π1|y + 3, n− y + 1)

P (π0 < W < π1|y + 1, n− y + 1)

−(

(y + 1)

(n+ 2)

P (π0 < W < π1|y + 2, n− y + 1)

P (π0 < W < π1|y + 1, n− y + 1)

)2

Ejemplo 3.2 Aplicacion Numerica del Caso Anterior Suponga quecreemos que el porcentaje de mujeres que actualmente estudia en la universidadesta entre el 35 % y el 70 %, o sea

ξ(π) =1

0,70 − 0,35para π ∈ (0,35, 0,70)

= 0 en otro caso.

Asumamos ademas que tomamos una muestra al azar de la poblacion de10 estudiantes y encontramos que 6 son hombres y 4 mujeres, o sea, y = 4 yn = 10. El intervalo de confianza clasico (clasico porque la mayorıa de los textosbasicos es el unico que presentan) basado en el teorema central del lımite, apesar del tamano muestral ser pequeno, dada la casi simetrıa de la distribucionpoblacional, se puede aplicar, sera

π ± 1,96

√π (1 − π)

n

lo que produce (0.0963, 0.703).La aproximacion bayesiana nos da una distribucion posterior

ξ (π|n = 10, y = 4, π0 = 0,35, π1 = 0,70) =

Γ(12)Γ(5)Γ(5)π

4(1 − π)6

K(0,70; 5, 7) −K(0,35; 5, 7)

donde

K(z;α, β) =

∫ z

0

Γ(α+ β)

Γ(α)Γ(β)xα−1(1 − x)β−1dx

Entonces

E (π|n = 10, y = 4, π0 = 0,35, π1 = 0,70) = 0,4823673

y un intervalo de credibilidad del 95 % es (0.3561442, 0.6680237). Este ultimose encuentra resolviendo

22 CAPITULO 3. TEOREMA DE BAYES

∫ π∗

π∗

Γ(12)Γ(5)Γ(5)π

4(1 − π)6

K(0,70; 5, 7) −K(0,35; 5, 7)dπ = 0,95

y formando el intervalo (π∗, π∗).

3.1. Usos de la Funcion de Verosimilitud en Anali-sis Bayesiano

Berger et a. (1998) presenta diferentes usos para la funcion de verosimilitud,L(θ):

1. Reporte Cientıfico: Se considera una buena practica de reporte presentarseparadamente L(θ) y ξ(θ|x), a menudo graficamente, para indicar el efectode la distribucion apriori. Esto le permite a otros investigadores utilizarsus propias distribuciones apriori.

2. Analisis de Sensibilidad: Es importante estudiar la sensibilidad a ξ(θ), ytener disponible L(θ) para este proposito es valioso.

3. Costo de Elicitacion: Obtener distribuciones apriori subjetivas es a menudomuy costoso, tanto en tiempo como en esfuerzo. Es a menudo efectivo anivel de costos eliminar los parametros de molestia de una forma basica,produciendo L(θ), y concentrar la elicitacion subjetiva a ξ(θ).

4. Objevitivismo: Aunque la “objetividad” no se puede garantizar en ningunestudio, el presentar L(θ) ayuda a darle esta impresion a muchos investi-gadores.

5. Combinacion de Verosimilitudes: Si se obtiene informacion sobre θ dediferentes fuentes independientes, y vienen con sus respectivas verosimili-tudes, digamos Li(θ), podemos resumir toda esta informacion como

∏i Li(θ).

Esta es la base del meta-analisis. De hecho, no se pueden multiplicar apos-terioris de esta forma.

6. Aprioris Impropias: Se reduce los peligros de utlizar aprioris impropias.

Capıtulo 4Distribuciones Conjugadas

Dada la magnitud de la tarea de determinar una distribucion apriori querefleje de una manera clara nuestra informacion bayesiana, uno intuitivamentepiensa en limitar la busqueda a familias de distribuciones apriori que poseanciertas caracterısticas, tales como:

1. Tratabilidad analıtica:

a) Facilidad de determinacion de la distribucion posterior de la muestray de la apriori.

b) Facilidad para obtener caracterısticas de interes, por ejemplo, valoresesperados.

c) La apriori y aposteriori deben ser miembros de la misma familia(cerrada).

2. Flexibilidad y riqueza: Debe permitir modelar una gran variedad de infor-macion apriori y creencias.

3. Interpretabilidad: Los parametros deben ser de tal forma que el analistapueda relacionarlos facilmente con sus creencias e informacion.

Las distribuciones conjugadas juegan un papel importante en los metodosbayesianos, ya que su uso puede simplificar el procedimiento de integracionrequerido para la marginalizacion. Ya que al pertenecer la apriori y la aposteri-ori a la misma familia, el proceso de actualizacion de parametros se simplifica(Ramoni y Sebastiani, 1998), lo cual es una gran ventaja para los sistemas in-teligentes.

La conjugacion nos limita a la seleccion de una clase de aprioris limitada y lainformacion apriori solo puede utilizarse para la seleccion de los hiperparamet-ros. Si la clase es lo suficientemente grande esto puede no ser un gran problema.

23

24 CAPITULO 4. DISTRIBUCIONES CONJUGADAS

4.1. Distribucion Binomial

Teorema 4.1 Suponga que X1, · · · ,Xn es una muestra aleatoria de una dis-tribucion Bernoulli con parametro π, donde el valor de π es desconocido. Tam-bien supongamos que la distribucion apriori de π es una beta con parametrosα(> 0) y β(> 0). Entonces la distribucion posterior de π cuando Xi = xi, parai = 1, · · · , n es una beta con parametros α+

∑ni=1 xi y β + n−∑n

i=1 xi.

SeanX1, · · · ,Xn variables aleatorias independientes Bernoulli(π). La verosimil-itud es

L(θ) ∝ π∑

iXi(1 − π)n−

∑iXi

El parametro π es univariable, y restringido al intervalo [0, 1]. La distribucionconjugada sera

ξ(π) ∝ πα−1(1 − π)β−1, con α, β > 0

α y β son llamados hiperparametros. Esta palabra se utiliza para distiguirlosdel parametro modelo muestral π. Si comparamos la apriori con la verosimilitudvemos que α−1 puede asociarse con

∑iXi y β−1 con n−∑iXi. Por lo tanto el

experto que debe expresar su informacion apriori puede realizar la tarea mentalde extraer una muestra imaginaria de 0’s y 1’s de tamano α+β− 2 y distribuirtanto los ceros y los unos como su imaginacion se lo dicte. El tamano de estamuestra imaginaria puede asociarse con el nivel de confianza subjetiva que elexperto tenga en sus asignaciones. Esta distribucion apriori se puede resumirmediante:

E(π) =α

α+ β

Moda =α− 1

α+ β − 2

V ariancia =αβ

(α+ β)2(α+ β + 1)=E(π)(1 − E(π))

α+ β + 1

La esperanza apriori E(π) corresponde a la probabilidad marginal de tenerun exito antes de obtener cualquier observacion:

E(π) =

∫πξ(θ) dπ =

∫p(Y = 1|π)ξ(π) dπ = p(X = 1)

Ya que la varianza de π es una funcion decreciente de α + β para una mediadada, la suma de los hiperparametros α+ β es tambien llamada la precision dela distribucion.

La distribucion posterior es

ξ(π|X1, · · · ,Xn) ∝ πα+∑

iXi−1(1 − π)β+n−

∑iXi−1

la cual es una distribucion beta con hiperparametros α+∑iXi y β+n−∑iXi.

Por lo tanto, la precision posterior se incrementa por el tamano muestral n.

4.1. DISTRIBUCION BINOMIAL 25

La media aposteriori se puede expresar como

α+∑ni=1Xi

α+ β + n=

(α+ β

α+ β + n

)(α

α+ β

)+

(n

α+ β + n

)(∑ni=1Xi

n

)

lo que es una media ponderada

E (π|X1, · · · ,Xn, α, β) = w · E(π|α, β) + (1 − w) ·∑ni=1Xi

n

donde w = (α+ β)/(α+ β + n).

Ejemplo 4.1 Este ejemplo es desarrollado por Draper (2000) y hace referen-cia a entradas de pacientes a un hospital universitario con Ataque Agudo delMiocardio (AAM). Se considera la tasa de mortalidad de los pacientes en los30 dıas siguientes a la admision al hospital. Se conoce que en Inglaterra estatasa es del 15 % (No necesariamente para este hospital la tasa sea igual). Paraelicitar la distribucion apriori sobre la proporcion de pacientes con AAM quemuere en lo 30 dıas siguientes, se utiliza esta informacion como, digamos elpromedio. Ahora se necesita un poco mas de informacion y el analista,tal vezusando el Teorema Central del Lımite, piensa que el 95 % de las posibles tasasde mortalidad para este hospital deben estar entre 5 % y 30 %. Debemos buscarpor lo tanto una distribucion Beta(α, β) que tenga una media de 0.15 y el areabajo la curva entre los lımites (0.05, 0.30) debe ser igual a 0.95. Mediante ensayoy error se encuentra que α = 4,5 y β = 25,5 se tiene una distribucion con lascaracterısticas deseada.

Escrito esto en forma jerarquica el modelo es

(α, β) = (4,5, 25,5) (Hiperparametros)

π|α, β ∼ Beta(α, β) (Apriori)

X1, · · · ,Xn ∼ Bernoulli(π) (Verosimilitud)

La funcion de verosilmilitud de los datos es

L(π) = p (X1, · · · ,Xn|π) = πS(1 − π)n−S ∝ Beta(S + 1, n− S + 1)

donde S =∑ni=1Xi. Si hemos observado 400 personas con AMM en el hospi-

tal, de los cuales 72 fallecieron en los siguientes 30 dıas, lo cual produce unaverosimilitud proporcional a una Beta(73, 329). La distribucion posterior sera,por lo tanto,

ξ(π|S = 72, n = 400) ∝ Beta(76,5, 353,5)

La informacion muestral equivalente en la distribucion apriori se puede aso-ciar con n∗ = α + β, en este caso es n∗ = 4,5 + 25,5 = 30. La informacionmuestral es muy grande con relacion a la apriori 400/30 es mas de 13 a 1.

26 CAPITULO 4. DISTRIBUCIONES CONJUGADAS

4.1.1. Elicitacion de los Parametros de la Beta para Pro-porciones

1. Determine la probabilidad r de que un elemento sacado al azar sea unexito. Esta probabilidad sera considerada como la media de la beta

r =α

α+ β

2. Dada la informacion que el primer elemento sea un exito, determine laprobabilidad, r+, de que el segundo elemento seleccionado al azar sea otroexito. La regla dice que la densidad actualizada es una Beta (α+ 1, β),ası que

r+ =α+ 1

α+ β + 1

3. Resuelva simultaneamente

α =r (1 − r+)

r+ − r

β =(1 − r) (1 − r+)

r+ − r

4. Chequee consistencia: Pregunte por la probabilidad de que el segundoartıculo sea un exito dado que el primero fue un fracaso, diga r−. Uti-lizando los valores de α y β calcule

r− =α

α+ β + 1

y compruebe si los valores elicitados concuerdan.

5. Si el resultado no es satisfactorio se pueden ajustar los valores de r yr+ or− hasta obtener un resultado consistente.

En lugar de una Beta

El modelo apriori Beta tiene limitaciones practicas para representar conocimien-to apriori sobre la proporcion. Gordy1 revisa algunos modelos y propone otropara representar una variable continua que este definida en un intervalo acotado.

1Gordi, B. M. (1998) A generalization of generalized beta distributions. Board of Governorsof the Federal Reserve System

4.1. DISTRIBUCION BINOMIAL 27

La Hipergeometrica Gaussiana (GH) tiene densidad

GH (x |p, q, r, λ ) =xp−1(1 − x)q−1(1 + λx)−r

B(p, q) 2 F1(r, p, p+ q,−λ)

para 0 < x < 1, p > 0, q > 0 y 2 F1 es la funcion gaussiana hipergeometri-ca. Cuando r = 0 o λ = 0 se tiene la beta ordinaria. Esta distribucion seha usado en analisis bayesiano.

La beta generalizada se define por

GB (x |a, b, c, p, q ) =|a|xap−1 (1 − (1 − c)(x/b)a)

q−1

bapB(p, q) (1 + c(x/b)a)p+q

para 0 < xa < ba/(1−c), 0 ≤ c ≤ 1, y b, p y q positivos. Cuando a = b = 0y c = 1 se tiene la beta prima.

Gordy propone la beta generalizada llamada hipergeometrica confluentey definida por

CH(x |p, q, s ) =xp−1(1 − p)q−1 exp (−sx)B(p, q) 1 F1(p, p+ q,−s)

para 0 < x < 1. La 1 F1 es la hipergeometrica confluente.

Gordy propone la hipergeometrica confluente compuesta definida por

CCH(x |p, q, r, s, ν, θ ) =xp−1(1 − νx)q−1(θ + (1 − θ)νx)−r exp(−sx)

B(p, q)H(p, q, r, s, ν, θ)

para 0 < x < 1/ν, p > 0, q > 0, r ∈ R, s ∈ R, 0 ≤ ν ≤ 1 y θ > 0. AdemasH esta dada por

H(p, q, r, s, ν, θ) = ν−p exp (−s/ν) Φ1 (q, r, p+ q, s/ν, 1 − θ)

con Φ1 es la funcion hipergeometrica confluyente definida por

Φ1(α, β, γ, x, y) =

∞∑

m=0

∞∑

n=0

(α)m+n(β)n(γ)m+nm!n!

xmyn

y donde (a)k es la notacion de Pochhammer, esto es, (a)0 = 1, (a)1 = ay (a)k = (a)k−1(a+ k − 1). Para esta distribucion el k-esimo momento secalcula como

E(Xk) =(p)k

(p+ q)k

H(p+ k, q, r, s, ν, θ)

H(p, q, r, s, ν, θ)

28 CAPITULO 4. DISTRIBUCIONES CONJUGADAS

4.2. Distribucion Binomial Negativa

Teorema 4.2 Suponga que X1, · · · ,Xn es una muestra aleatoria de una dis-tribucion binomial negativa con parametros r y π, donde r tiene una valor es-pecıfico (r > 0) y el valor de π es desconocido. Tambien supongamos que ladistribucion apriori de π es una beta con parametros α(> 0) y β(> 0). Entoncesla distribucion posterior de π cuando Xi = xi, para i = 1, · · · , n es una beta onparametros α+ rn y β +

∑ni=1 xi.

4.3. Distribucion Geometrica

Otra distribucion de conteo popular es la geometrica, la cual cuenta elnumero de fracasos antes de obtener el primer exito. Su funcion de probabilidadesta dada por

P (X = k) = (1 − π)πk k = 0, 1, 2, · · ·

Su media es π/(1 − π) y su varianza π/(1 − π)2. El sesgo es (1 + π)/√π.

4.4. Distribucion Multinomial

Definicion 4.1 (Distribucion Dirichlet) El vector aleatorio X = (X1, · · · ,Xk)′

se distribuye como una Dirichlet con vector de parametros α = (α1, · · · , αk)′ con

αi > 0; i = 1, · · · , k, si la p.d.f. f(x|α) para x = (x1, · · · , xk) y∑ki=1 xi = 1

esta dada por:

f(x|α) =Γ(α1 + · · · + αk)

Γ(α1) · · ·Γ(αk)xα1−1

1 · · ·xαk−1k

La media de Xi es

E(Xi) =αiα0

donde α0 =∑ki=1 α1.

La varianza de Xi es

var(Xi) =αi(α0 − αi)

α20(α0 + 1)

y la covarianza entre Xi y Xj es, (i 6= j),

Cov(Xi,Xj) = − αiαjα2

0(α0 + 1)

4.5. DISTRIBUCION POISSON 29

Teorema 4.3 Suponga que Y = (Y1, · · · , Yk)′ tiene una distribucion multino-mial con parametros n (fijo) y W = (W1, · · · ,Wk)

′, desconocidos. Suponga tam-bien que la distribucion apriori de W es una Dirichlet con vector de parametrosα = (α1, · · · , αk)′ con αi > 0; i = 1, · · · , k. Entonces la distribucion posteriorde W cuando Yi = yi, i = 1, · · · , k, es una distribucion Dirichlet con vector deparametros α∗ = (α1 + y1, · · · , αk + yk)

′.

Gustafson y Walker (200*) extienden el problema a datos multinomialeslongitudinales. Ellos penalizan la distribucion apriori Dirichlet para mermarel impacto de grandes cambios en las probabilidades en puntos sucesivos deltiempo. Si denotamos

ξD(π|α) =Γ(α1 + · · · + αk)

Γ(α1) · · ·Γ(αk)πα1−1

1 · · ·παk−1k

Entonces esta funcion es reemplazada por

ξ(πi|σ

)= c(σ)

T∏

t=1

ξD(πi,t|α = 1)

exp

(− 1

σ2

T∑

t=2

∣∣∣∣πi,t − πi,t−1∣∣∣∣2)

donde ||·|| es la norma euclıdea, y σ es un hiperparamtero que debe ser especifi-cado. La i hace referencia al i-esimo sujeto. Claramente σ gobierna el grado en elcual la apriori favorece los pequenos cambios en el tiempo. En particular valoresgrandes de σ corresponden a menos favoritismo, con independencia surgiendocuando σ → ∞.

4.5. Distribucion Poisson

El modelo de conteo mas utilizado es el modelo Poisson ya que su desarrolloteorico es claro y muchos problemas reales pueden modelarse muy bien de estaforma. Decimos que una variable aleatoria de conteo X se distribuye Poisson(θ)si su funcion de probabilidad esta dada por

f(x) =θx exp(−θ)

x!x = 0, 1, 2, 3, · · ·

Para esta distribucion se tiene que E(X) = V ar(X) = θ.

Teorema 4.4 Suponga que X1, · · · ,Xn es una muestra de una distribucionPoisson con media desconocida θ. Tambien supongamos que la distribucion apri-ori de θ es una gamma con parametros α(> 0) y β(> 0). Entonces la distribucionposterior de θ cuando Xi = xi, para i = 1, · · · , n es una gamma con parametrosα+

∑ni=1 xi y β + n.

30 CAPITULO 4. DISTRIBUCIONES CONJUGADAS

4.6. Distribucion Exponencial

La distribucion exponencial tiene funcion de densidad de probabilidad dadapor

f(x) = θe−θx x ∈ (0,∞)

Teorema 4.5 Suponga que X1, · · · ,Xn es una muestra de una distribucion ex-ponencial con parametro desconocido θ. Tambien supongamos que la distribucionapriori de θ es una gamma con parametros α(> 0) y β(> 0). Entonces la dis-tribucion posterior de θ cuando Xi = xi, para i = 1, · · · , n es una gamma conparametros α+ n y β +

∑ni=1 xi.

4.7. Distribucion Normal

La distribucion normal es la mas ampliamente conocida y utilizada distribu-cion en el trabajo estadıstico. Hay basicamente dos razones para ello:

Muchas poblaciones pueden ser modeladas aproximadamente por esta dis-tribucion.

Como resultados lımites se llega a ella en muchas situaciones.

Su funcion de densidad es

f(x) =1√2πσ

exp

(−1

2

(x− µ)2

σ2

)

con soporte x ∈ (−∞,∞). Su funcion de distribucion acumulada se denotaΦ(x), su media es µ y su varianza σ2. Esta distribucion posee dos parametros,lo cual nos lleva a considerar diferentes situaciones. La precision es el inverso dela varianza.

4.7.1. Precision Conocida

Teorema 4.6 Suponga que X1, · · · ,Xn es una muestra aleatoria de una dis-tribucion normal con un valor desconocido de la media µ y un valor especificadode la precision r (r > 0).

Distribucion Apriori: µ ∼ N (µ0, τ0) donde τ0 es la precision, tal que−∞ < µ0 <∞ y τ0 > 0.

Distribucion Posterior:

(µ|X = x) ∼ N (µ1, τ1)

donde

µ1 =τ0µ0 + nrx

τ0 + nrτ1 = τ0 + nr es la precision

y x es la media muestral.

4.7. DISTRIBUCION NORMAL 31

Prueba: (Ejercicio)

Observe que la media posterior se puede expresar como

µ1 =τ0µ0 + nrx

τ0 + nr=

nr

τ0 + nrx+

τ0τ0 + nr

µ0

Se ve claramente que la media posterior es una media ponderada de la mediaapriori y la media muestral.

4.7.2. Precision Desconocida

Este tipo de problema surge en control de calidad cuando lo que interesacontrolar es la variabilidad de un proceso determinado.

Teorema 4.7 Suponga que X1, · · · ,Xn es una muestra aleatoria de una dis-tribucion normal con un valor conocido de la media m (−∞ < m < ∞) y unvalor desconocido de la precision W (W > 0).

Distribucion Apriori: W ∼ Gamma2 (α0, β0) donde α0 > 0 y β0 > 0.

Distribucion Posterior:

(W |X = x) ∼ Gamma (α1, β1)

donde

α1 = α0 +n

2

β1 = β0 +1

2

n∑

i=1

(xi −m)2.

Prueba: (Ejercicio)

4.7.3. Media y Precision Desconocidas

Este caso, a pesar de lo simple que puede parecer, muestra la complejidad a laque puede llegar a enfrentar el estadıstico ante la presencia de varios parametros.

Teorema 4.8 Suponga que X1, · · · ,Xn es una muestra aleatoria de una dis-tribucion normal con un valor desconocido de la media µ y un valor desconocidode la precision R (R > 0).

2Asumimos una gamma de la forma

f(x) =βα

Γ(α)xα−1e−βx

32 CAPITULO 4. DISTRIBUCIONES CONJUGADAS

Distribucion Apriori Conjunta de µ y R:

1. La distribucion condicional de µ cuando R = r es µ ∼ N (µ0, τ0r)donde τ0r es la precision, tal que −∞ < µ0 <∞ y τ0 > 0, y

2. la distribucion marginal de R es Gamma (α0, β0) donde α0 > 0 yβ0 > 0.

Distribucion Posterior Conjunta de µ y R cuando X = x:

1. La distribucion condicional de µ cuando R = r es

(µ|X = x) ∼ N (µ1, τ1)

donde

µ1 =τ0µ0 + nx

τ0 + n

τ1 = (τ0 + n)r

y x es la media muestral.

2. la distribucion marginal de R es Gamma(α1, β1) donde

α1 = α0 +n

2

β1 = β0 +1

2

n∑

i=1

(xi − x)2

+τn (x− µ0)

2

2(τ + n)

Prueba: (Ejercicio)

4.8. Distribucion Gamma

La distribucion gamma ha sido ampliamente aplicada en confiabilidad y enpruebas de vida. Decimos que la variable aleatoria X tiene una distribuciongamma con parametros β y α si su densidad es

f(x|α, β) =βα

Γ(α)xα−1 exp (−βx) x > 0, α > 0

donde α denota el parametro de forma y β es el recıproco de un parametro deescala. Si x1, x2, · · · , xn es una muestra aleatoria de esta distribucion, entoncesla funcion de densidad conjunta es

n∏

i=1

f(xi|α, β) =βnα

[Γ(α)]npα−1 exp (−sβ)

4.8. DISTRIBUCION GAMMA 33

donde

s =n∑

i=1

xi

p =

n∏

i=1

xi

Miller (1980) usa una clase conjugada muy general definida por la conjunta

ξ(α, β) ∝ βν′α−1

[Γ(α)]n′(p′)

α−1exp (−s′β)

donde α > 0, β > 0, n′ > 0, ν′ > 0, s′ > 0 y p′ > 0, tal que n′(p′)1/n′

/s′ < 1.La distribucion posterior es proporcional a

ξ(α, β|x) ∝ βν′′α−1

[Γ(α)]n′′p′′α−1

exp (−s′′β)

donde ν′′ = ν′ + n, p′′ = p′p, s′′ = s′ + s y n′′ = n′ + n.La distribucion condicional de β dado α es una Gamma (ν′′, s′′), y la dis-

tibucion marginal posterior de α es proporcional a

Γ (ν′′α)

[Γ(α)]′′

(r′′

n′′

)ν′′α

donde

r′′

n′′=

ν′′√p′′

s′′=

(p′)1/(ν′+n)(r/n)n/(ν

′+n)sn/(ν′+n)

s′ + s

34 CAPITULO 4. DISTRIBUCIONES CONJUGADAS

Capıtulo 5Distribuciones No Informativas

El uso de distribuciones apriori no informativas buscan que ellas tengan unimpacto mınimo sobre la distribucion posterior del parametro de interes y quesea relativamente plana con relacion a la verosimilitud. Esto busca que seanlos datos los que tengan un claro dominio en la distribucion posterior, y, porlo tanto, en todas las inferencias que de ellas se obtengan. Tambien se conocencomo vagas, difusas, planas o de referencia. Estas distribuciones no informativasse reunen en dos grupos:

Propias: Cuando la distribucion de probabilidad integra a una constante finita,se dice que es propia. Por ejemplo, para el caso de la distribucion bino-mial, su parametro π, que denota el porcentaje de exitos en la poblacion,podemos asumir como apriori la U(0, 1), lo cual refleja nuestra ignoranciatotal, al asumir que cualquier valor en este intervalo es igualmente posiblecomo valor.

Impropias: Una distribucion apriori ξ(θ) es impropia si

∫

Θ

ξ(θ) dθ = ∞

Notas:

1. Una distribucion apriori impropia puede terminar en una aposteriori im-propia y por lo tanto no se podran hacer inferencias.

2. Una distribucion apriori impropia puede llevar a una aposteriori propia.

Ejemplo 5.1 Asumamos que y1, · · · , yn|θ son variables distribuidas normal eindependientemente con media θ y con varianza conocida σ2. Asumamos queξ(θ) ∝ 1 es la distribucion apriori uniforme (impropia) sobre los numeros reales.La verosimilitud es

35

36 CAPITULO 5. DISTRIBUCIONES NO INFORMATIVAS

L (θ|y) ∝ exp

(−n

2

(y − θ)2

σ2

)

y la distribucion posterior es

θ|y ∼ N

(y,σ2

n

)

la cual es una distribucion propia.

Yang y Berger (1998) presentan varias razones por las cuales es importanteconsiderar las distribuciones no informativas. Tenemos entre ellas

Con frecuencia la elicitacion de las distribuciones apriori es imposible, pormultiples razones, por ejemplo, limitaciones de costo o tiempo, o resisten-cia o falta de entrenamiento de los clientes.

El analisis estadıstico debe aparecer como “objetivo”.

La elicitacion subjetiva puede producir malas distribuciones subjetivas,por ejemplo si la elicitacion es sesgada.

En problemas de alta dimension, lo mas que se puede esperar es obtenerbuenas distribuciones subjetivas para algunos pocos parametros, y a losparametros de perturbacion se les asignan distribuciones no informativas.

El analisis bayesiano con distribuciones no informativas puede utilizarsepara obtener procedimientos clasicos buenos.

Aun cuando un investigador tenga creencias apriori fuertes, puede ser masconvincente analizar los datos utilizando una apriori de referencia dominada porla verosimilitud. Ademas podemos automatizar el proceso de hallar aprioris.Yang y Berger (1998) proporcionan un amplio catalogo de distribuciones noinformativas que es util en el trabajo aplicado.

5.1. El Principio de la Razon Insuficiente de Laplace

Si el espacio parametral es finito se puede utilizar una distribucion aprioriuniforme para reflejar ignorancia total.

5.2. Apriori de Jeffreys

La distribucion apriori de Jeffreys satisface la propiedad local de uniformidadpara distribuciones apriori no informativas. Esta apriori esta basada en la matrizde informacion de Fisher. Jeffreys la propuso como una “regla general” paradeterminar la distribucion apriori (Kass y Wasserman, 1994).

5.2. APRIORI DE JEFFREYS 37

Definicion 5.1 Sea f (x|θ) la densidad de x dado θ. La informacion de Fisheres definida como

I(θ) = −E[∂2 log (f (x|θ))

∂θ2

]

Si θ es un vector de p componentes, entonces

I(θ) = −E[∂2 log (f (x|θ))

∂θi ∂θj

]

p×p

y entonces I(θ) sera una matriz de dimension p× p.

Definicion 5.2 La distribucion apriori de Jeffreys se define como

ξ(θ) ∝ |I(θ)|1/2

La distribucion apriori de Jeffreys es localmente uniforme y por lo tanto noinformativa. Esta propiedad es importante ya que nos proporciona un esquemaautomatizado para hallar distribuciones apriori no informativas para cualquiermodelo parametrico (Ibrahim, 2002). Esta distribucion es impropia para muchosmodelos, sin embargo, es propia para algunos.

Ejemplo 5.2 Asumamos que y1, · · · , yn son variables distribuidas independi-entemente Bernoulli(π). Encontremos la distribucion apriori de Jeffreys paraπ.

La densidad para una variable Bernoulli(π) es

p(y|π) = πy(1 − π)1−y

Entonces tenemos

log (p(y|π)) = y log(π) + (1 − y) log(1 − π)

∂

∂πlog (p(y|π)) =

y

π− 1 − y

1 − π

∂2

∂π2log (p(y|π)) = − y

π2− 1 − y

(1 − π)2

I(π) = −E[∂2

∂π2log (p(y|π))

]

=E(y)

π2+

1 − E(y)

(1 − π)2=

1

π+

1 − π

(1 − π)2

=1

π+

1

1 − π=

1

π(1 − π).

Por lo tanto la distribucion apriori de Jeffreys es

38 CAPITULO 5. DISTRIBUCIONES NO INFORMATIVAS

ξ(π) ∝ I(π)1/2

=

(1

π(1 − π)

)1/2

= π−1/2(1 − π)−1/2

= π1/2−1(1 − π)1/2−1

Ası π ∼ Beta(

12 ,

12

). Por lo que vemos en este caso la distribucion apriori de

Jeffreys es propia.

Ejemplo 5.3 Asumamos que y1, · · · , yn|µ son variables distribuidas normal eindependientemente con media µ y con varianza σ2 desconocidas. calculemos ladistribucion apriori de Jeffreys para (µ, σ)

f (x|µ, σ) =1√2πσ

exp

(− 1

2σ2(x− µ)

2

)

log (f (x|µ, σ)) = −1

2log(2π) − log(σ) − 1

2σ2(x− µ)

2

∂ log (f (x|µ, σ))

∂µ=

1

σ2(x− µ)

∂2 log (f (x|µ, σ))

∂µ2= − 1

σ2

∂ log (f (x|µ, σ))

∂σ= − 1

σ+

1

σ3(x− µ)2

∂2 log (f (x|µ, σ))

∂σ2=

1

σ2− 3

σ4(x− µ)2

∂2 log (f (x|µ, σ))

∂µ∂σ= − 2

σ3(x− µ)

Tomando la esperanza obtenemos

I((

µσ

))=

[1σ2 00 2

σ2

]

Ası la distribucion apriori sera

ξ(µ, σ) ∝∣∣∣∣I((

µσ

))∣∣∣∣1/2

=

(1

σ2× 2

σ2

)1/2

∝ 1

σ2

5.3. OTRAS ALTERNATIVAS 39

Esta distribucion apriori de Jeffreys es impropia.

La distribucion apriori de Jeffreys tiene la propiedad de invarianza, ya quepara cualquier otra transformacion uno a uno sigue siendo no informativa. Estosurge de la relacion

I(θ) = I(ψ(θ))

(dψ(θ)

dθ

)2

donde ψ(θ) es una transformacion uno a uno de θ. Ası

(I(θ))1/2

= (I(ψ(θ)))1/2

∣∣∣∣dψ(θ)

dθ

∣∣∣∣

Note que∣∣∣dψ(θ)dθ

∣∣∣ es el valor absoluto del jacobiano de la transformacion de θ a

ψ(θ). Ası

(I(θ))1/2

dθ = (I(ψ))1/2

dψ

La apriori de Jeffreys preserva la escala en parametrizaciones.

Ejemplo 5.4 Supongamos x ∼ N(µ, 1). La distribucion apriori de Jeffreys paraµ es ξ(µ) ∝ 1. Sea ψ(µ) = eµ. Esta es una transformacion uno a uno en µ. Lacorrespondiente apriori de jeffreys para ψ(µ) es

(I(ψ(µ)))1/2 = (I(µ))1/2∣∣∣∣dψ(µ)

dµ

∣∣∣∣−1

= 1 × e−µ

= e−µ

Ası la distribucion apriori de Jeffreys para ψ(µ) = eµ es

ξ(µ) ∝ e−µ, −∞ < µ <∞.

La propiedad de invarianza significa que si tenemos una distribucion apriorilocalmente uniforme en θ, y si ψ(θ) es una funcion uno a uno de θ, entoncesξ (ψ(θ)) es una distribucion apriori localmente uniforme para ψ(θ).

5.3. Otras Alternativas

Definicion 5.3 (Distribucion Apriori de Maxima Entropıa) Cuando θ esunivariable y puede tomar cualquier valor sobre la recta real, y la media y la var-ianza apriori estan especificadas, la distribucion apriori de maxima entropıa esla Normal con la media y la varianza especificadas.

40 CAPITULO 5. DISTRIBUCIONES NO INFORMATIVAS

Kass y Wasserman (1994) presentan la definicion planteada por Novick yHall:

Definicion 5.4 (Distribucion Apriori Indiferente) Se define una distribu-cion apriori indiferente si identificando una clase de conjugadas se seleccionauna apriori de esta clase que satisfaga:

La apriori debe ser impropia y

una “muestra mınima necesaria” debe inducir una posterior propia.

Un ejemplo de la anterior definicion es claro en el problema binomial, con laclase conjugada de las Betas, la distribucion apriori π(1 − π)−1

es una aprioriindiferente.

Box y Tiao (1973) proponen el uso de distribuciones apriori localmente uni-formes, las cuales consideran el comportamiento local de la apriori en una regiondonde la verosimilitud es apreciable, pero la apriori no se asume grande por fuerade esa region.

5.4. Marginalizacion

Ejemplo 5.5 Eliminando un termino de molestia. En muchas situacionestenemos un vector de parametros, pero solo estamos interesados realmente enunos pocos. Debemos por lo tanto proceder a “eliminar” aquellos terminos demolestia. Esto lo hacemos mediante la marginalizacion. Suponga que x1, · · · , xnes una muestra aleatoria de una N

(µ, σ2

), donde

(µ, σ2

)son desconocidos. Sea

τ = 1/σ2. Suponga que especificamos una apriori no informativa de Jeffreys

ξ(µ, σ2

)∝ τ

Ahora,

ξ (µ, τ |x) ∝ τn2 −1 exp

−τ

2

n∑

i=1

(xi − µ)2

.

Ası, para eliminar el termino nuisance τ marginalizamos

ξ (µ |x) ∝∫ ∞

0

τn2 −1 exp

−τ

2

n∑

i=1

(xi − µ)2

dτ.

No es difıcil llegar a

ξ (µ |x) ∝∫ ∞

0

τn2 −1 exp

−τ

2

n∑

i=1

(xi − x)2

exp

−nτ

2(x− µ)

2dτ.

Sea

5.4. MARGINALIZACION 41

s2 =1

n− 1

n∑

i=1

(xi − x)2

Entonces

ξ (µ |x) ∝∫ ∞

0

τn2 −1 exp

−τ

2

((n− 1)s2 + n(µ− x)2

)dτ

∝((n− 1)s2 + n(µ− x)2

)−n/2

∝(

1 +n

(n− 1)s2(µ− x)2

)−(n−1+1)/2

Ası

µ|x ∼ t

(n− 1, x,

s2

n

)

Por lo tanto

µ− x

s/√n∼ t(n−1)

A pesar de haber llegado a un resultado que es de uso comun en la estadısticaclasica, la interpretacion aquı es diferente.

Ejemplo 5.6 Eliminando otro termino de molestia. En el ejemplo anteriorsupongamos que el termino de molestia es µ. Debemos por lo tanto halla ξ (τ |x).procedemos de manera similar

ξ (τ |x) ∝∫ ∞

−∞

τn2 −1 exp

−τ

2

((n− 1)s2 + n(µ− x)2

)dµ

∝ τn−1

2 −1 exp−τ

2

((n− 1)s2

)

Ası

τ |x ∼ Gamma

(n− 1

2,(n− 1)s2

2

)

De lo anterior obtenemos que

(n− 1)s2τ ∼ ξ2n−1

42 CAPITULO 5. DISTRIBUCIONES NO INFORMATIVAS

Capıtulo 6Inferencia Bayesiana

6.1. Estimacion Puntual

Dada una distribucion sobre un parametro particular, digamos θ, requerimosseleccionar un mecanismo para escoger un “buen” un estimador θ. Supongamosque θ0 es el verdadero parametro, desconocido. Sea d nuestra adivinanza de estevalor. Debemos de alguna forma medir el error que cometemos (digamos queesto puede ser una multa o un pago) al adivinar a θ0 mediante d. Esto puede

ser medido por (d− θ0)2

o por |d− θ0| o mediante alguna otra funcion.Un problema estadıstico puede resumirse como (S,Ω,D, L), donde

S: Es el espacio muestral de un experimento relevante que tiene asociada unavariable aleatoria X cuya distribucion de probabilidad esta parametrizadapor un elemento de Ω.

Ω: Espacio parametral (en un sentido amplio)

D: Un espacio de decisiones

L: Una funcion de perdida.

Una vez un problema estadıstico ha sido especificado, el problema de infer-encia estadıstica es seleccionar un procedimiento (estadıstico), a veces llamadouna funcion de decision, que nos describe la forma de tomar una decision unavez un resultado muestral ha sido obtenido.

Definicion 6.1 Una funcion de decision o procedimiento estadıstico es una fun-cion o estadıstico d que mapea de S a D.

Definicion 6.2 Sea D un espacio arbitrario de decisiones. Una funcion no neg-ativa L que mapea de Ω ×D a R es llamada una funcion de perdida.

43

44 CAPITULO 6. INFERENCIA BAYESIANA

Definicion 6.3 El valor esperado de L(θ, d(X)) cuando θ es el verdadero valores llamada la funcion de riesgo

R(θ, d) = Eθ [L (θ, d(X))] =

∫L (θ, d(x)) dPθ(x)

Funcion de Perdida Cuadratica:

L(d, θ) = (d− θ)2

Miremos el riesgo para esta funcion de perdida. Sea

b = Eξ(θ|x)(θ) =

∫θ ξ (θ|x) dθ

el promedio de la distribucion aposteriori. Entonces

E [L(d, θ)] =

∫L(a, θ) ξ (θ|x) dθ

=

∫(a− b+ b− θ)2 ξ (θ|x) dθ

= (a− b)2 +

∫(b− θ)2 ξ (θ|x) dθ

≥∫

(b− θ)2 ξ (θ|x) dθ

,

para cualquier valor de d. La desigualdad anterior se convierte en igual-dad cuando d = b. El estimador bayesiano bajo una funcion de perdidacuadratica es la media de la distribucion posterior.

Funcion de Perdida Error Absoluto:

L(d, θ) = |d− θ|

El riesgo es minimizado tomando d como la mediana de la distribucionposterior, digamos d∗. O sea, la mediana es el estimador bayesiano cuandola funcion de perdida es el valor absoluto. Para mostrar esto supongamosotra decision tal que d > d∗. Entonces

|θ − d| − |θ − d∗| =

d∗ − d si θ ≥ d,d+ d∗ − 2θ si d∗ < θ < d,d− d∗ si θ ≤ d∗.

Ya que (d + d∗ − 2θ) > (d∗ − d) cuando d∗ < θ < d, entonces el siguienteresultado se consigue

6.1. ESTIMACION PUNTUAL 45

E(|θ − d| − |θ − d∗|) ≥ (d∗ − d)P (θ ≥ d) + (d∗ − d)P (d∗ < θ < d)

+(d− d∗)P (θ ≤ d∗)

= (d− d∗) [P (θ ≤ d∗) − P (θ > d∗)] ≥ 0

Esta ultima desigualdad sigue del hecho que d∗ es la mediana de la distribucionde θ. La primera desigualdad en este conjunto de ecuaciones sera una igualdadsi, y solo si, P (d∗ < θ < d) = 0. La desigualdad final sera una igualdad si, ysolo sı,

P (θ ≤ d∗) = P (θ > d∗) =1

2.

Estas condiciones implican que d es tambien una mediana. Por lo tanto, E(|θ−d|) ≥ E(|θ − d∗|), y la igualdad se cumple si, y solo si, d es tambien mediana.

Una prueba similar puede hacerse si d < d∗.

Funcion de Perdida Escalonada:

L(d, θ) = 0 si |d− θ| ≤ δ

= 1 si |d− θ| > δ

donde δ es un numero predeterminado, usualmente pequeno.

E [L(d, θ)] =

∫

Θ

I (|d− θ| > δ) ξ (θ|x) dθ

=

∫

Θ

I (1 − (|d− θ| ≤ δ)) ξ (θ|x) dθ

= 1 −∫ d+δ

d−δ

ξ (θ|x) dθ

≈ 1 − 2δξ (d|x)

Para minimizar el riesgo es necesario maximizar ξ (d|x) con respecto a d y elestimador bayesiano es el maximizador. Por lo tanto, el estimador bayesianosera el que maximiza la posterior, esto es, el valor modal. Este estimador esllamado el estimador maximo-aposteriori (MAP).

Una estimacion que puede ser utilizada en una o mas dimensiones, espe-cialmente cuando la funcion de perdida no ha sido definida explıcitamente, esel valor del parametro en el cual se maximiza la disribucion posterior. Paracualquier observacion de x, sea ψ(·|x) que denota la distribucion posterior deW en el espacio parametral Ω. Sea w(x) el valor de w que satisface la relacion

46 CAPITULO 6. INFERENCIA BAYESIANA

Ejemplo 6.1 Estimacion Puntual de la Media de una Poblacion Nor-mal con Varianza Conocida

Datos: y = (y1, y2, · · · , yn)′. Asumimos que yi ∼ N(θ, σ2), para todoi = 1, 2, · · · , n. y la varianza es conocida.

Distribucion Apriori para θ:

θ ∼ N(µo, σ

2o

),

o

ξ(θ) ∝ exp

(−1

2

(θ − µo)2

σ2o

)

Verosimilitud:

f(y|θ, σ2

)=

n∏

i=1

1√2πσ2

exp

(− (yi − θ)

2

2σ2

)

∝ exp

(−

n∑

i=1

(yi − θ)2

2σ2

)

Distribucion Aposterior: Se aplica la regla de Bayes

ξ (θ|y) ∝ ξ(θ) · f(y|θ)∝ ξ(θ) · L (θ|)

∝ exp

(−1

2

(θ − µo)2

σ2o

)exp

(−

n∑

i=1

(yi − θ)2

2σ2

)

∝ exp

(−1

2

(θ − µo)

2

σ2o

+n∑

i=1

(yi − θ)2

σ2

)

La distribucion posterior se puede reorganizar y mostrar que

θ|y ∼ N(µn, σ

2n

)

donde

µn =

1σ2

oµo + n

σ2 y

1σ2

o+ n

σ2

=τoµo + nry

τo + nr

y1

σ2n

=1

σ2o

+n

σ2

6.1. ESTIMACION PUNTUAL 47

Bajo las tres funciones de perdida el estimador bayesiano para la media sera

θ = µn.

Ejemplo 6.2 PoissonSea y1, · · · yn una muestra aleatoria de una Poisson(λ). Supongamos tam-

bien que la apriori es unaGamma(1, 1). Por lo tanto la aposterior seraGamma(1+∑ni=1 yi, n+ 1).El estimador bayesiano para λ

bajo la funcion de perdida cuadratica es

λ =1 +

∑ni=1 yi

n+ 1

bajo la funcion de perdida escalonada

λ =α∗ − 1

β∗=

∑ni=1 yin+ 1

si α∗ ≥ 1

La siguiente funcion en R calcula los tres estimadores, bajo el supuesto deuna aprori Gamma(α0, β0) :

calcula.estimadores.poisson<-function(alfa0,beta0,x,n=lenght(x))

alfa1<-alfa0+sum(x)

beta1<-beta0+n

estimador.fpc<-alfa1/beta1

estimador.fpa<-qgamma(0.5,alfa1,beta1)

estimador.fpe<-(alfa1-1)/beta1

list(estimador.fpc=estimador.fpc,

estimador.fpa=estimador.fpa,

estimador.fpe=estimador.fpe)

La utilizacion sera

>calcula.estimadores.poisson(1,1,16,n=4)

$estimador.fpc

[1] 3.4

$estimador.fpa

[1] 3.333571

$estimador.fpe